【DG】 IntraDA & DG survey

- Paper: Unsupervised Intra-domain Adaptation for Semantic Segmentation through Self-Supervision

- Type: DA

- Reference site: CVPR oral presentation*

흥미로운 Paper List

1) Contrastive Syn-to-Real Generalization [paper, code] = Transfer Learning 목적으로 하는 DG 모델

IntraDA 핵심요약

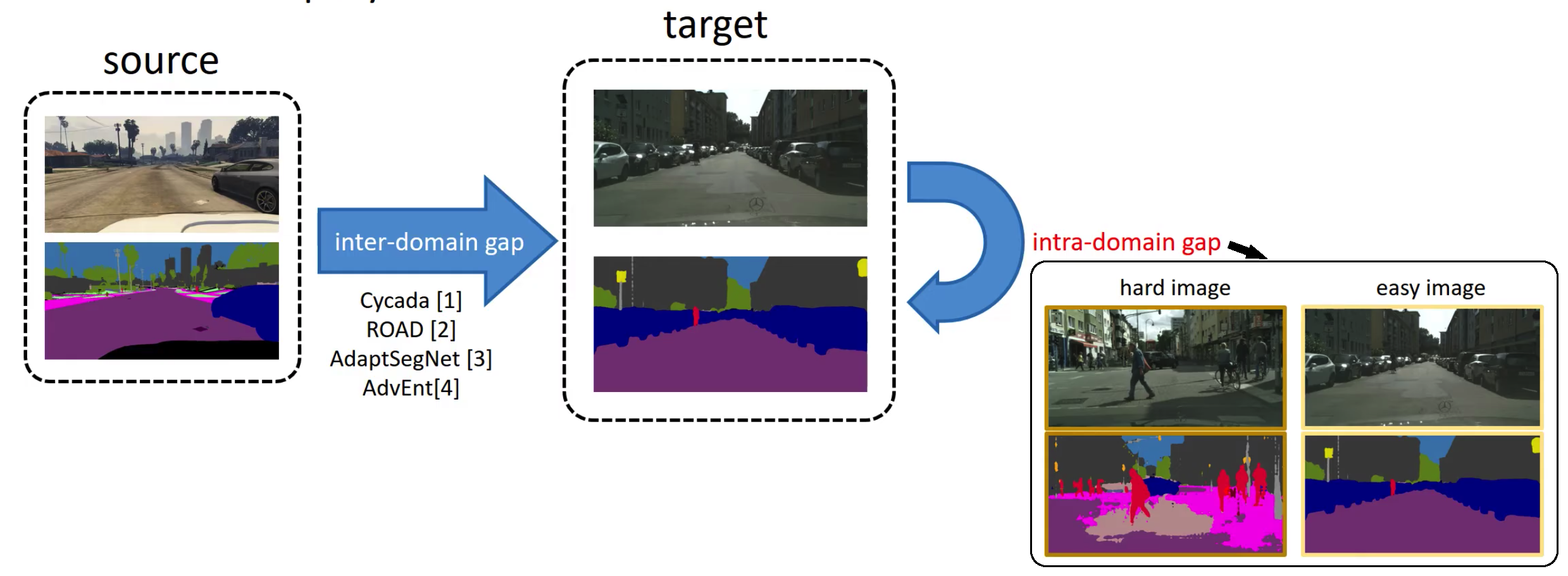

Domain Gap의 종류 2가지

- Inter-domain gap: Source와 Target 간의 Doamin gap.

- Intra-domain gap: Target 내부에서 Hard와 Easy Image의 gap

위 2가지 Gap을 모두 줄이기 위해 노력한다!!

Method 핵심

- Target domain에서

Entropy-based ranking function을 사용해, Easy와 Hard로 분리한다. - Easy images의 pseudo labels을 사용해서 Hard Images와의 Intra-Domain Adaptation을 수행한다.

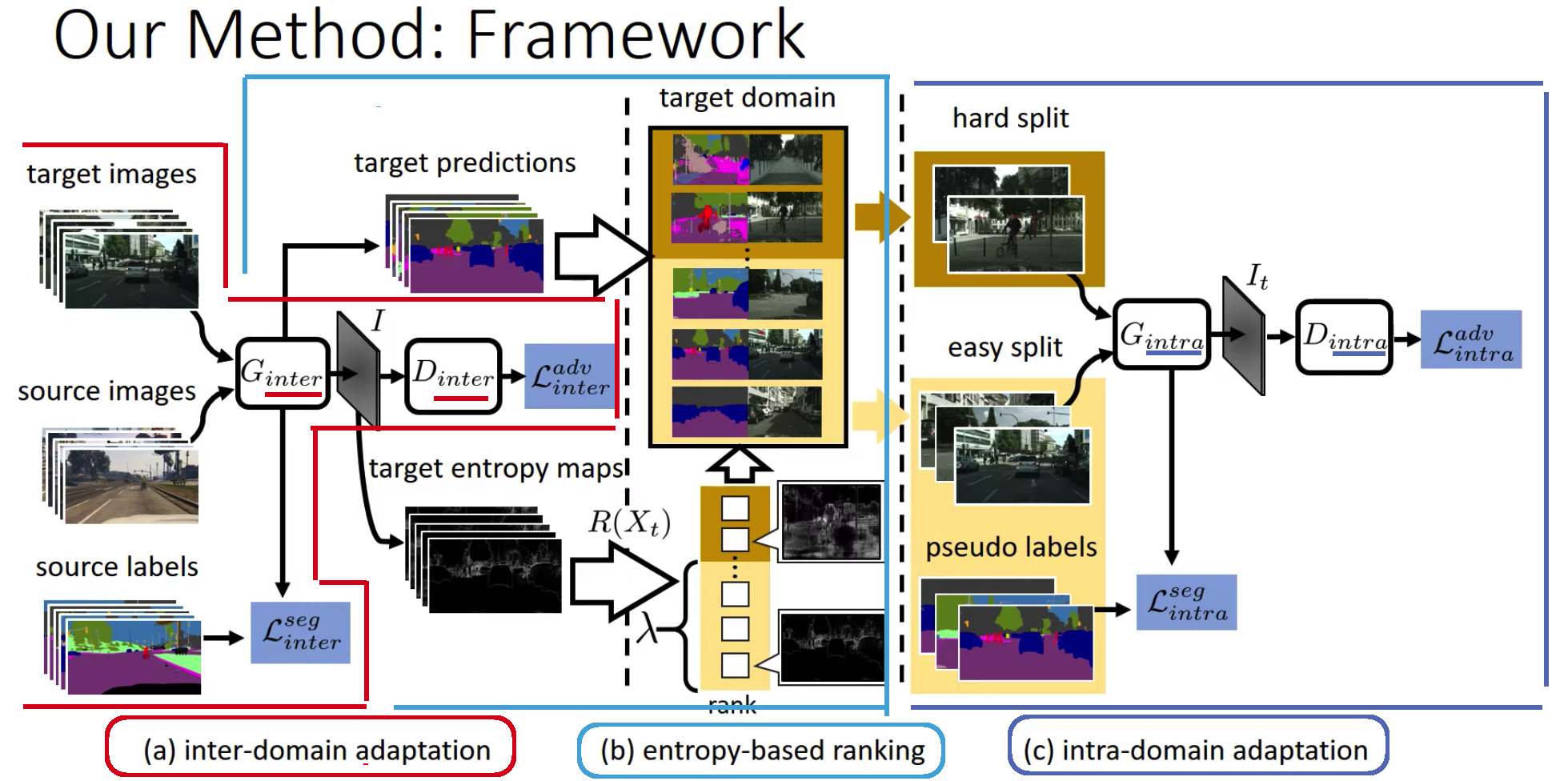

- 전체 프레임은 3개로 구성되어 있다. (1) Inter-domain Adaptation (2) Entropy-based Ranking System (3) Intra-domain Adaptation

- Inter-domain adaptation

- ADVENT 그대로.

- the Entropy of predictions 사용

- Entropy-based ranking

- 위에서 학습된 Generater사용한다.

- Target image의 prediction과 Entropy가 생성된다.

- Lambda는 hard와 easy의 비율.

- Intra-domain adaptation

- Intra-Generator와 Intra-Discriminator로 구성되어 있다.

- Intra-Generator는 Target Easy Image의 Segmentation 결과를 생성한다.

Domain Generalization Survey 핵심 요약

진짜 핵심만 작성해라!!! 너무 당연한 얘기. 대강 알것 같은 이야기는 적지 말아라! 위에서 했던 소리 또한 다시 적지 말아라!!

1. Introduction & Related Topics

- DG: 오직 source만을 사용해서, out-of-distribution data = unseen data에 대한 일반화 성능 향상을 목표로 한다.” 이를 위한 방법으로 domain alignment, meta-learning, data augmentation, ensemble learning 과 같은 기법을 기반으로 사용한다.

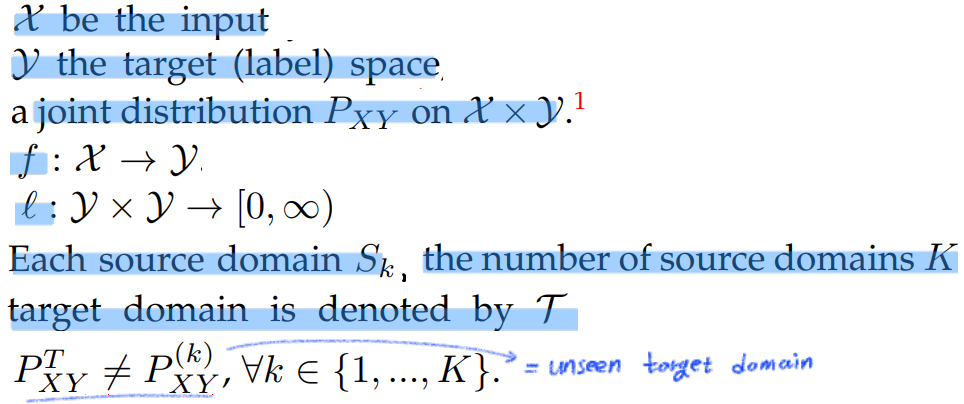

- 용어 정리

- DG 종류

- Multi-source DG

- Single-source DG

- Homogeneous DG: the same set of classes 를 예측한다.

- Heterogeneous DG: the different set of classes 를 예측한다. Zero-shot DG 라고도 할 수 있다. 새로운 클래스를 인지하는데도 도움이 되는

generalizable feature representation를 학습하는 것을 목적으로 한다.

- Domain을 고려하는 Task들의 종류

- Supervised Learning

- Multi-Task Learning: 대부분 파라미터를 쉐어링하는 방법으로 모델 만든다.

- Transfer Learning := fine-tunning. 최근 이 관점의 DG works들은 transferable features(Adjustable parameter)를 만드는 것을 목적으로 한다.

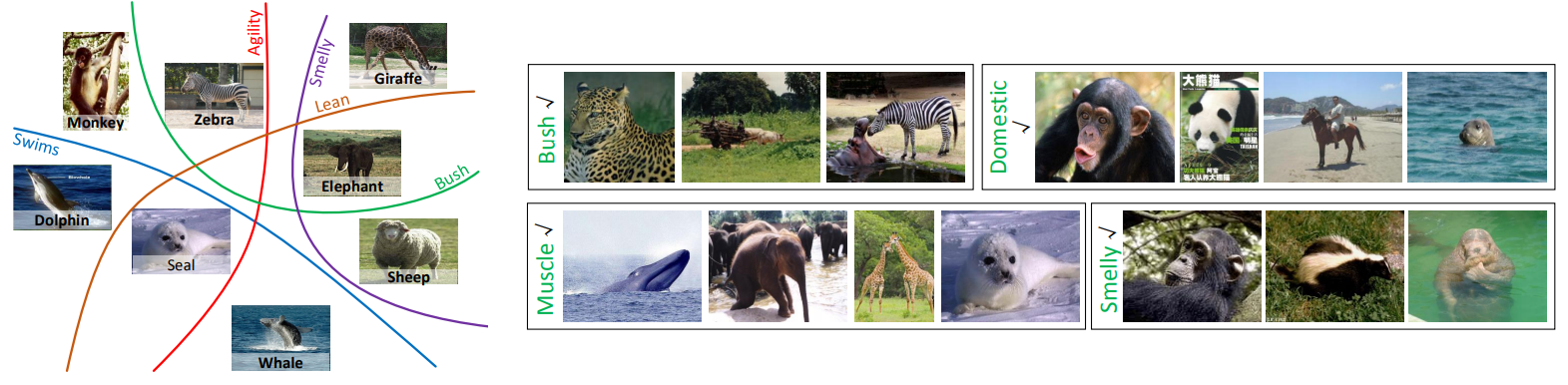

- Zero-shot learning: Class space changes를 고려해고, 새로운 Class도 예측할 줄 알게 만드는 것이 목적이다. attributes(클래스 특성)을 학습하는게 목적이다. attribute에 대한 예시는 아래와 같다.

2. METHODOLOGIES

2.1 Domain Alignment

- Source 데이터들 사이의 (이미지 혹은 Feature) 차이를 최소화하여 Invariant feature 생성을 목표로 한다.

- Distance 계산하는 방법

- Dot Similarity

- L2 distance

- f-divergences

- KL-divergences

- Wasserstein distance

- softmax

- 여기서 나는 느꼈다. 아 여기 논문들 너무 고전이다.

2.2 Meta-Learning

2.3 Data Augmentation

2.4 Ensemble Learning2.5 Network Architecture Design

2.6 Self-Supervised Learning

2.7 Learning Disentangled Representations

2.8 Invariant Risk Minimization

2.9 Training Heuristics

2.10 Side Information

Survey 논문 읽기 그만!

과거의 기술들이 많이 나온다. 하지만 그래서 문제다. 너무 과거의 기술들만 나온다. 또한 좋은 학회의 기술들만 나오는 것도 아니다. 따라서 나는 아래와 같은 결론을 내린다. 지금 WACV를 위해서 내가 해야하는 건 아래가 전부다.

- 최신 논문의 BaseLine 코드 찾기 (학습시간 오래 걸리지 않는것)

- 해당 논문 내용을 토대로, 지금 내가 가진 지식을 총 동원해서 아이디어 추가하기

- 가능하면 다른 분야의 논문 지식을 융합해서, 아이디어 만들기. DG 관련 논문만 너무 줄구장창 읽지 말자. 차라리 DG 논문은 핵심 및 최신 논문만 읽고, 다양한 분야의 논문들을 접해보자. 아니면 Object Detection 최신 논문도 조금씩 따라가자.

- 따라서 Survey 논문은 지금 내가 해야할게 아니다.