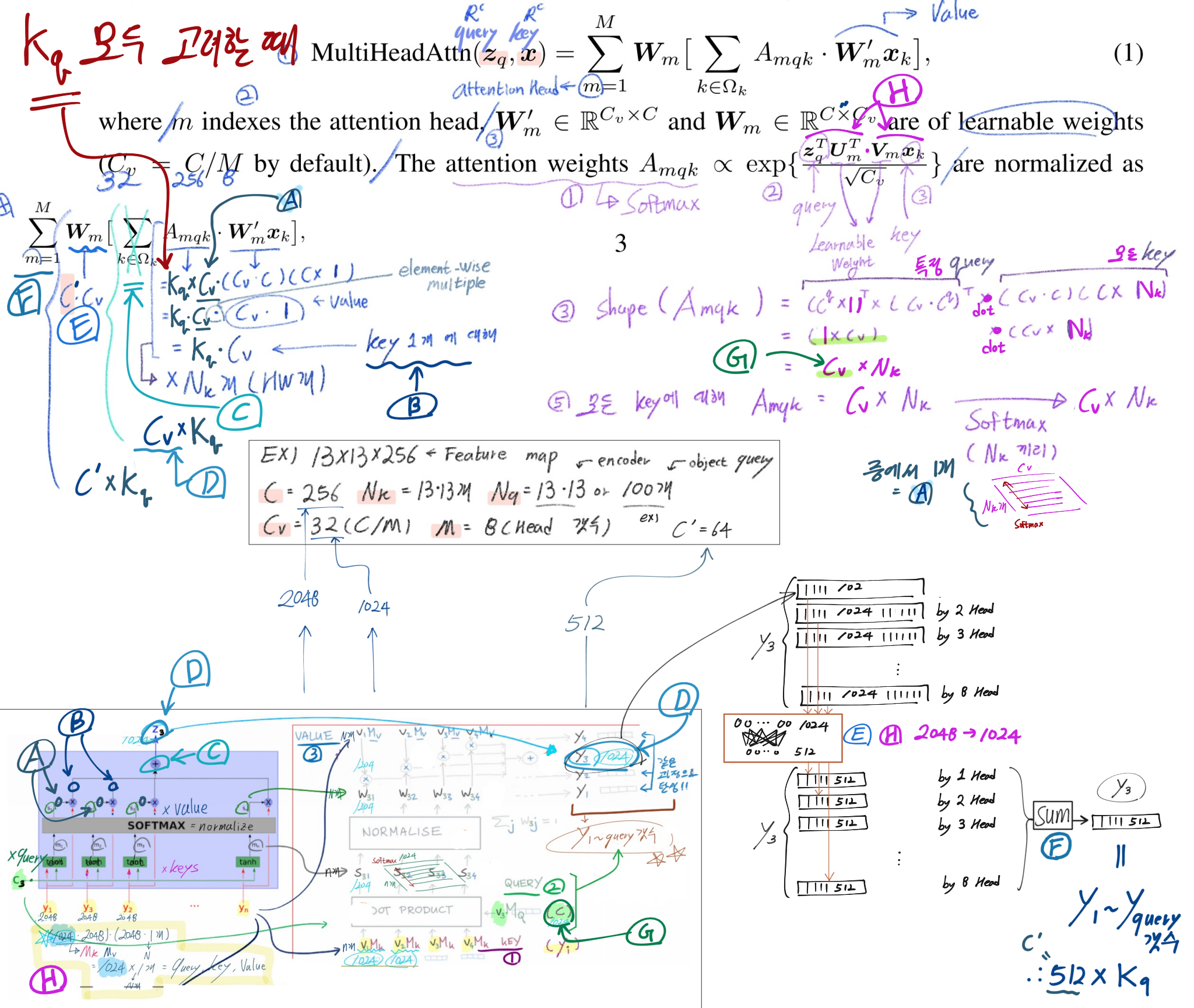

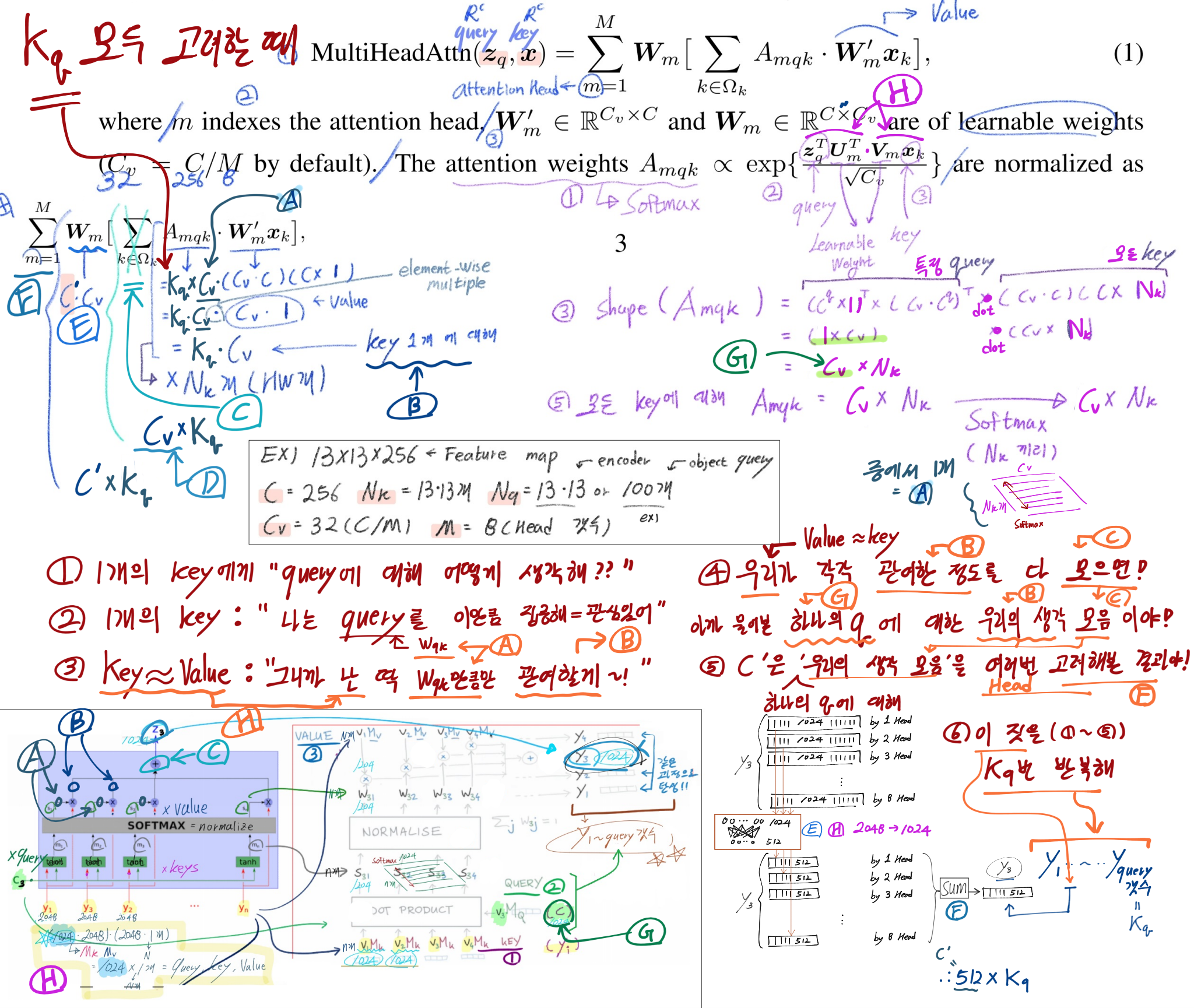

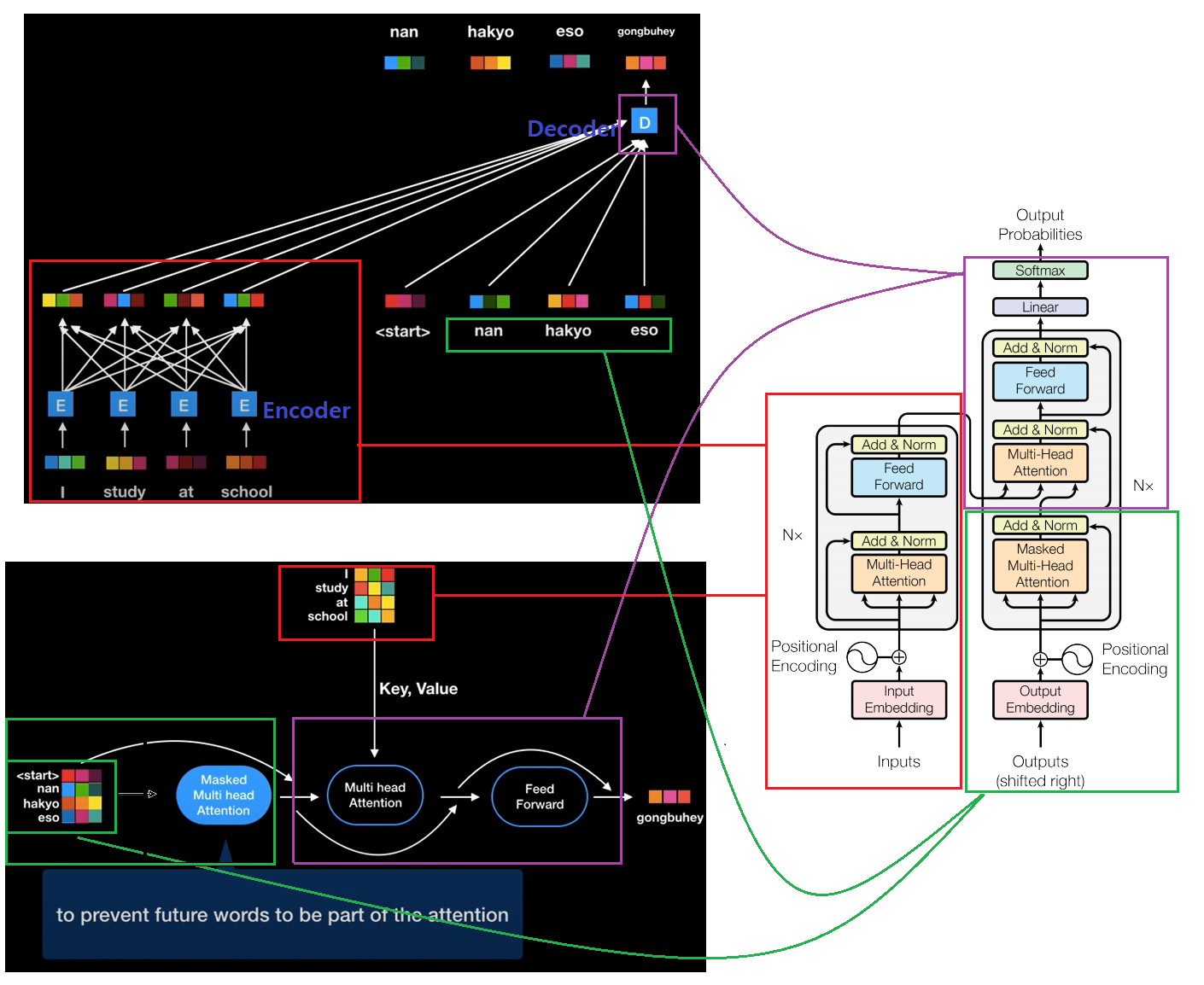

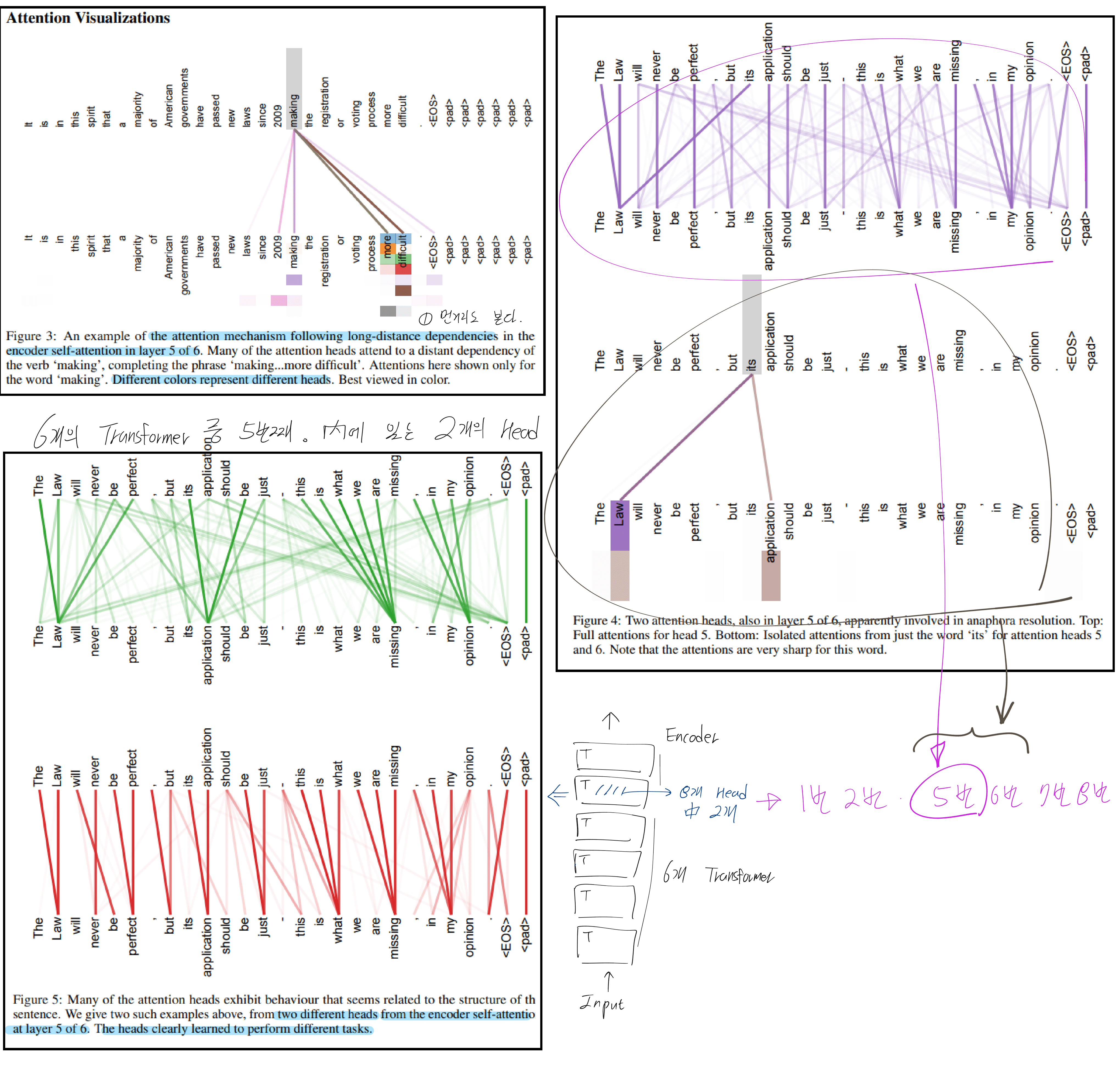

【Transformer】Attention Is All You Need 공부 필기

- 논문 : Attention Is All You Need

- 이 논문은 그리 자세하지 않다.

- 직관적인 이해를 위해서, 이곳 저곳에서 글을 찾아 읽고 공부했다.

- 과거의 Post(Attention Mechanism Overveiw) 에서 정리한 내용에 추가적으로 공부한 내용이다.

- ViT (16x16 Vision Transformer ) 논문에서는 Encoder만을 사용했다. 따라서 Multi Head Attention 모듈만 이해하면 됐지만, DETR에서는 Decoder까지 이해하기 때문에 Decoder까지의 완벽한 이해가 필요했다.

- 참고 자료

- 과거의 Post(Attention Mechanism Overveiw)에 적혀있는 Reference

- Youtube1 : https://www.youtube.com/watch?v=mxGCEWOxfe8

- 아래 필기 공부 순서 : 맨 아래 그림 -> 보라색 -> 파랑색 -> 대문자 알파벳 매칭 하기